◎賴文智律師

本文刊登於國家文化記憶庫網站創用CC專區(https://tcmb.culture.tw/zh-tw/ccarticle/285)

資料授權 CC BY-NC 3.0 TW

2022年11月Open AI公司推出以LLM(大型語言模型)為基礎的ChatGPT服務後,因為其跨語言、跨領域的回應能力,促成生成式AI風潮席捲全球。然而,對於政府機關(構)或民間企業,除了成本考量之外,生成式AI面臨的全新法律風險,包括:著作權、營業秘密、個人資料及回應的正確性等,也都是令其等對於導入生成式AI服務遲疑的原因。

然而,近二、三十年來由國家資源所推動之博物館、圖書館數位化,已累積為數相當多的數位館藏,文化部更是歷年編列預算推動國家文化記憶庫,集結全台灣各機構及民間團體,可對外透過創用CC開放授權的數位資源。以LLM技術開發之生成式AI服務,因其以語言作為人工智慧發展的專業領域,使得所有得以透過語言學習的領域,像是:對話或文章生成、文件摘要、翻譯、語音轉文字、程式設計等,都是此類生成式AI專精的領域。

博物館或圖書館可以想像若導入生成式AI,就如同招聘一名數位館員,可以大量「閱讀」數位館藏,甚至比任何一位資深館員都更能掌握數位館藏的基本資訊,可以擺脫目前的搜尋、檢索頁面,直接以口語的方式掌握使用者的需求。如果博物館、圖書館的館藏數位化,是透過網路將博物館、圖書館送到使用者家中,那麼,若能導入生成式AI服務,可能就相當於將圖書館員送到使用者慣用的設備上,隨時都可以就教圖書館員,更進一步地使用數位館藏,發揮數位館藏真正的服務潛能。

筆者以下即由生成式AI法律風險的介紹,說明目前相當熱門的RAG技術對於前開風險解決的基本架構,再針對擁有大量數位館藏的單位如何應用RAG架構導入LLM的生成式AI服務進行介紹。

一、生成式AI的法律風險

(一)著作權

生成式AI的著作權風險,主要來自於LLM預訓練時,需要大量的訓練資料,為了符合現代使用的需求,也不可能都使用舊資料。因此,幾乎可以確認目前市面上的LLM模型,幾乎在最開始的時候,都可能利用未經合法授權的資料進行預訓練。不過,從著作權法的角度來觀察,生成式AI提供服務時,並不需要像過去的資料庫服務一樣,使用到原始的訓練資料,反而是更像人類學習。我們在寫作的時候,固然可能有自己的風格,但必然使用到一些先前學習過的知識、素材,只是這些因為學習的過程被轉化了。生成式AI在提供服務時依賴的是「算力」,而非原始訓練資料。所以,導入生成式AI服務時,有關訓練資料的爭議,應該是由進行訓練的業者承擔,而非導入生成式AI服務的機關(構)。吾人可以關心生成式AI訓練資料的著作權爭議,但卻不需要等到這類爭議全部塵埃落定才決定是否導入,因為這個議題通常不會延燒到服務使用者身上。

另一個著作權相關議題則是生成式AI產出的成果,可能侵害他人著作權的風險。生成式AI的目標在於生成新的成果,所以,基本上,並不會直接像人類的抄襲一樣,拿取特定資料的特定段落直接使用,比較可能是因為在某些情境下(或者說是訓練過程所學習的「印記」),在生成的過程中將具有「關聯性」的資訊結合在一起,呈現出與過去既存的著作相似的成果。舉例來說,若使用者刻意輸入與蝙蝠俠相關背景及引導其類似的故事大綱,生成的小說可能會與既存的蝙蝠俠的故事情節相似,而可能構成著作權侵害。這樣的侵權風險,主要還是取決於使用者如何使用生成式AI服務。

(二)機敏資訊的保密

無論是個人資料或是營業秘密的外洩,都是機關(構)、企業在導入生成式AI最關注的法律議題。但這個議題反而是服務模式選擇與內部控管的議題,而非源於生成式AI技術的本質。對於大型企業而言,自行添購硬體設備,透過開源的生成式AI模型,如Google的Bard、Anthropic的Claude,或像Meta的Llama 2、3這類開放授權的基礎模型,在企業內部以自己整理、清洗過的資料進行訓練或提供服務,有關機敏資訊保密的問題,大致上可以解決。

但對於資源較少的機構或企業、組織,選擇像Open AI的ChatGPT提供生成式AI服務時,同樣可以選擇透過API串接,而非如同一般使用者直接透過Web或App使用服務。因為Open AI為降低機構型使用者對於機敏資訊保護的疑慮,已經聲明透過API串接提供ChatGPT服務,並不會自動將使用者所上傳的資訊納入訓練資料。若是真的非不得已只能透過Web或App使用這類服務,可能只能透過制定相關控管的規範,進行適當的員工訓練,以避免員工將包含機敏資訊的內容使用於生成式AI服務。

(三)正確性

生成式AI主要是透過「關聯性」而非「邏輯推演」進行生成,AI生成的內容看似合理且正確,但其實AI只是生成一個前後具有關聯性的文字的堆疊,因此,很可能會發生前後文看起來很順暢,但其實內容是不正確的。這樣的技術特性也與經常會被提到的歧視有關,因為生成式AI在進行預訓練時,即使是大量的資料,相對於全世界存在的各種層級的資料而言,仍然是有限的。

認識到生成式AI技術上的限制,選擇將生成式AI使用於其專精的領域,而非過度期待其可應用在所有領域,並且透過「真人」進行最後對外提供利用時的檢核,以及對可能的受眾提示該內容為AI生成,讓受眾也注意「正確性」可能有疑義,是目前降低生成式AI正確性風險的主要方式。當然,隨著AI技術的發展,正確性的問題也可能透過技術的方式逐漸降低。本文以下介紹的RAG技術,即是目前常見的一種折衷方案。

二、RAG—結合本地資料源與生成能力的處理架構

(一)RAG(檢索增強生成)簡介

RAG (Retrieval-Augmented Generation)由字義來看,就是自外部取回資訊增強後生成回應,是一種結合外部資料庫的搜尋檢索和生成能力的自然語言處理架構,中文常譯為檢索增強生成或擷取增強生成,用以提高生成式AI模型準確性和可靠度[1]。舉例言之,博物館或圖書館的網站上會整理常見問題,讓使用者自助閱讀,但其編排還是依據館員的思維架構,使用者未必容易找得到心中問題的解答。RAG架構可以將預先編寫好的常見問題集作為外部資料庫,限定AI回覆只能由這些常見問題集中進行生成回應內容,若是常見問題集沒有相關的Q&A,AI就會回答不知道或其他預設的回應(如請聯絡專人等)。但因為其與使用者溝通的界面及回應仍然是以生成式AI為之,使用者可以用最自然的對話方式進行與理解,且因回應受到特定規則的限制,不致於遇到「一本正經胡說八道」的生成回應。對於需要比較嚴謹、正確回應的服務而言,服務提供者只要專注於強化自有的資料庫即可。

(二)RAG與具外部檢索功能或微調(fine-tunning)LLM模型的差異

相較於具有外部檢索能力的生成式AI服務,如ChatGPT 4o已可以結合部分外部的檢索資料回應使用者的詢問,但其外部搜尋仍然可能找到不適合的資料用以生成回答,且其生成的內容主要受到原先預訓練資料的影響,未必符合需求。例如:因為預訓練簡體資料量遠高於繁體中文資料,所以,即令使用者要求以繁體中文回答,還是會夾雜出現簡體中文,即令要求將信息改為資訊,將數據改為資料,回答還是會出現這類不那麼適合的內容。若透過RAG架構,則因為主要回應的資料來源是可以控制的,自然能夠大幅提昇回應的正確性;而較早期政府機關或大型企業可能透過微調(fine-tunning)的方式,透過專有的資料對於LLM模式進行客製化的訓練,如TAIDE計畫。但微調(fine-tunning)所需要資料量及算力成本過高,並不是單一的博物館或圖書館可以負擔。

簡言之,RAG架構可以將原本就很強大的LLM模型的自然語言AI,透過擷取外部資料庫及其運算、生成相關設定,將服務範圍擴展到特定領域或機構組織的專屬知識庫,無需重新訓練專有(客製化)的LLM模型。個別的博物館或圖書館不需要像TAIDE計畫一樣蒐集大量資料訓練一個適合台灣環境使用的LLM模型,只需要著重於自有資料庫的建置及RAG相關技術的調整,即可打造出一個熟讀自有資料庫全部內容的數位館員,可以回應使用者任何與該資料庫有關的問題,也不會不受控地生成該資料庫沒有的幻想內容。

三、國家文化記憶庫結合RAG可能的應用

國家文化記憶庫(https://memory.culture.tw)透過收存系統及介接文化部及各典藏機構,共匯聚超過300萬筆數位影像資料及相關說明文字,透過網站對外提供服務。然而,也正是因為這樣龐大的數位資料,導致國家文化記憶庫在民眾接近使用上,造成相當程度的困難。舉例來說,若以「大稻埕」作為關鍵字進行搜尋,「查詢結果3,062筆 含時間記錄2,067筆 含空間記錄914筆」,使用者未必對於國家文化記憶庫網站相關查詢功能能快速掌握技巧,查詢結果過多又需要逐一辨識,其結果就是國家文化記憶庫的數位資源無法被有效率地看見與利用。因此,在推廣方面即需相關單位額外投注心力,邀集專家、廠商以策展的概念,向民眾宣導國家文化記憶庫豐富的館藏。然而,相較於龐大數量的數位館藏,能夠透過這類策展被看見的資源仍然極其有限,而這正是生成式AI的機會。

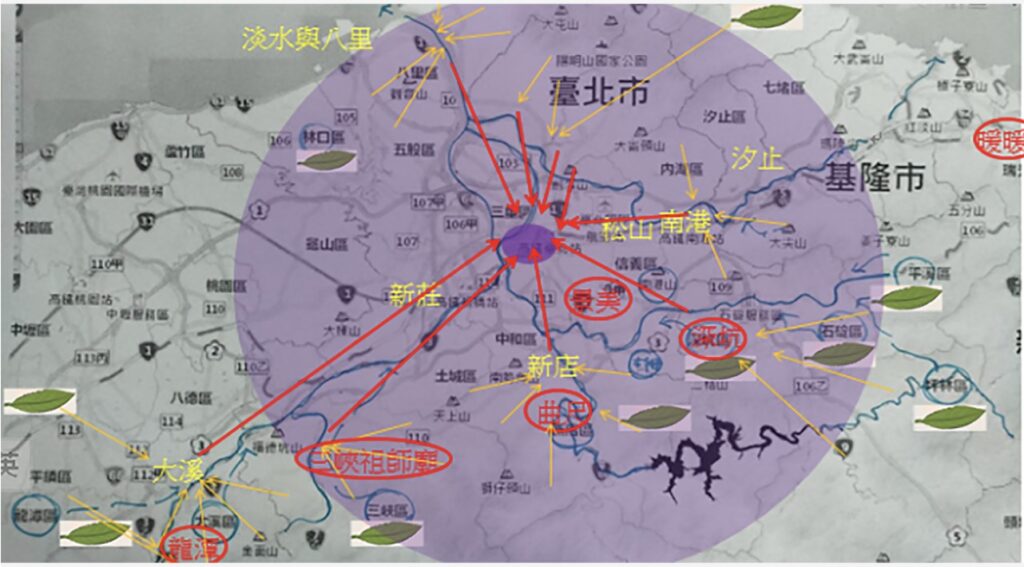

日據初期以前淡水河河運茶葉集散圖。建檔單位:國立台灣工藝研究發展中心。數位物件授權:CC BY(姓名標示)。發佈於《國家文化記憶庫》,https://cmsdb.culture.tw/place/EF7CF345-5B4A-4C5C-92DF-D6AD17BD7AF4

大量的數位館藏對於人類而言是一件困難的事,但對於AI卻只是單純數量的問題,只要有足夠的算力與時間,300萬筆資料並不是件難事。採購適當的AI運算硬體,安裝開源的LLM模型,搭配前開介紹的RAG架構,即可推出由生成式AI為核心的數位館員服務,使用者可以輕鬆利用口語對話的方式,例如:提供有關大稻埕在1850年至1900年茶葉交易相關資料,並說明其時代背景及所代表之意義。因為使用LLM自然語言模型,數位館員會解析使用者的問題,再摘錄其中的關鍵資訊至國家文化記憶庫的資料進行檢索與生成。在採取RAG架構下,數位館員僅會針對資料庫的內容生成具有關聯性的回答內容,並可呈現原始資料來源(其生成內容的主要依據來源)。透過適當的設計,任何人在生成式AI降低專業門檻的協助下,均可以對於自己有興趣的議題,透過國家文化記憶庫的數位館藏進行互動式的數位策展。這樣的模式,對於擁有自己數位館藏的博物館、圖書館都可以適用,即令沒有辦法自建LLM模型,仍然可以透過像串接ChatGPT等服務搭建RAG架構對外提供生成式AI服務,讓更多使用者得以自己的方式接近、使用數位館藏。

四、資料治理為導入生成式AI降低法律風險的基礎

然而,博物館或圖書館擬將其數位館藏作為前述RAG架構下對外提供生成式AI服務,其前提在於作為RAG外部資料庫,數位館藏必須是能夠由博物館或圖書館合法對外提供服務使用。以國家文化記憶庫為例,其所介接及收錄之數位資源,除不受著作權法保護或著作財產權保護期間已屆滿之資源外,多為透過創用CC對外開放授權之資源。因此,無論是前述的著作權、個人資料或營業秘密等法律風險,都不是太大的問題。在未導入生成式AI服務之前,這些資源都是合法透過國家文化記憶庫網站對外公開提供瀏覽或利用。

對於其博物館或圖書館的數位館藏而言,若過去未透過網路對外公開提供服務,或是上網公開前未經過適當的法律風險評估,應該先進行資料合法性的盤點,確認該等數位館藏得由博物館或圖書館對外提供服務。RAG架構只是使這類LLM模型外接資料庫的數位館藏,作為提昇生成式AI回答「正確性」的解決方案,而博物館或圖書館則須對於數位館藏本身可能涉及的著作權、個人資料或營業秘密的法律風險,透過資料權利盤點,生命周期的管理來處理。由於AI的發展或應用都脫離不了資料,有意就其數位館藏導入AI服務的博物館,無論採取何種模式,都須強化內部資料治理,這才是降低法律風險的最佳方式。

[1] 有關RAG架構的詳細簡介與應用架構,請參,劉育維,RAG 檢索增強生成— 讓大型語言模型更聰明的秘密武器,https://blog.infuseai.io/rag-retrieval-augmented-generation-introduction-a5854cb6393e, 2024/5/31 visited.